机器人:是指蜘蛛搜索引擎抓到的第一个文件

指定蜘蛛抓取的内容,不抓取

网站管理员然后可以让机器人文件夹蜘蛛的规定,爬行和不爬行。

影响:

1,禁止私人内容的抓取

2,为了排名

3,统一路径,这样有两条路径

阻止网站毫无价值的网页

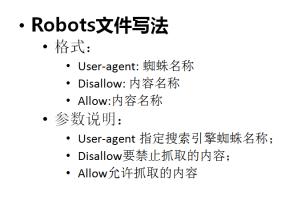

写作机器人的规则

1,user-agent:*提供了不同的蜘蛛

2,禁止:禁止(屏蔽)蜘蛛爬行

3,允许:允许爬行

4,*:全部

禁止:/ wp * ban(域名)/ wp

5,最后$

不允许:/ *,js $禁止js结束

网站地图

注意事项

1,想写英文

2,1空间后。 准备好域名的地方。 山猫是空的2格。

3,首字母大写

4,遵守,遵循星系的规则

例:

不允许:/ dede / shield dede文件夹

ALLOW:/ dede / 1,Html允许dede下

网站安全

disallow:/ dede后台修改网站,让人知道你的背景

禁止:/ ab / shield文件夹不允许:/ ab

disallow:/ ab *最后两个角色相同

不允许:/ ab是角色,相当于ab,屏蔽所有,屏蔽整个网站,/不能使用空格

在盾牌之前的线上。 在线删除,不推荐,排名将被延长

(1)本地站

(2)临时域名,不是爬蜘蛛,有包括可以被屏蔽

(3)二级域名

不要阻止官方域名

共同屏蔽

(1)中国的道路

(2)动态路径

(3)搜索结果页面

(4)js

(5)模板目录

(6)插件目录

怎么写:

suer_ar_agent:*

seoshipin:/? s = *

通过FTP上传到网站的根

不允许:/链接

不允许:/ tag / *。 不是指文件夹

不允许:/ *,js $

模板不参与排名

禁止:/模板/

了解网站文件,链接。 看链接找到法律

最后提交并测试,提交给百度站长平台。 网站管理员工具

文章来源于:湖南seo:http://www.yunxiuseo.com/1446.html